Как правильно настроить индексирование сайта в поисковых системах

Содержание:

- Дублирование

- Как происходит индексация?

- Способы проверки индексации сайта

- Как проверить индексацию сайта

- Как сделать индексацию быстрее?

- Как сделать так, чтобы Google индексировал обратные ссылки быстрее

- Чего делать точно не стоит?

- Что делать, если сайт плохо индексируется?

- Плюсы и минусы службы индексирования файлов

- Как Гугл и Яндекс проверяют страницы на качество

- Отличия индексации сайта от сканирования

- Типы роботов поисковых систем

- Что такое индексация сайта?

- Правильные шаги оптимизации сайта

- Проверка индексации с помощью операторов URL и SITE

- Что такое индексация обратных ссылок

- Что такое индексация сайта в поисковых системах?

- Заключение

Дублирование

Подразумевает наличие нескольких идентичных страниц одного сайта, в которых содержится одинаковый контент.

Виды дублей:

-

страницы, адрес которых различается знаком «/». Например, «www.primer_saita.ru/Tovar/cart/GM928» и абсолютно аналогичный «…/GM928/». Часто встречается такая ситуация с карточкой одного и того же товара, которая относится к разным категориям (коньки, подходящие, как для девочек, так и для мальчиков);

-

дубли-страницы с незначащими параметрами, которые не воспринимает робот-поисковик. Примеры некоторых незначащих элементов для робота-поисковика, можно увидеть ниже:

Неприятности, которые могут возникнуть из-за дублей:

-

бот поисковой системы, вместо индексации необходимого и корректного адреса может посещать и анализировать множество ненужных страниц;

-

в базу данных поиска робот-анализатор может включить только одну страницу из всех возможных дублей, опираясь на свое усмотрение.

Как бороться с дублированными страницами:

Прописать атрибут rel= «canonical» тега со своим значением, то есть «выделить» страницу, расставив «приоритеты» цепочкой. Например, есть две страницы:

Допустим, что предпочитаемый адрес, который нам нужен – это вторая ссылка. Тогда, в первой странице необходимо прописать в ее html-коде следующую строчку:

Важно! Алгоритм анализа поисковым роботом устроен таким образом, что не считает данную директиву строгой, поэтому бот рассматривает ее, как предполагаемый вариант, который может быть проигнорирован!

-

«редирект 301», о котором мы уже говорили ранее. Особенно актуален в случаях дублей страниц с «/» и без него;

-

В файле robots.txt прописать параметры «disallow» (запрет доступа) и «clean-param» (учитывание динамических параметров (id сессий и др.), не влияющие на содержимое страницы). Пример таких дублей мы рассмотрели чуть ранее.

Где можно выявить дубли? Все в том же Вебмастере. В сервисе от «Яндекса» заходим в раздел «Индексирование», затем «Проверить статус URL», вводим ссылку, анализируем результат.

Как происходит индексация?

Чтобы понять лучше принципы этого процесса, стоит детальнее рассмотреть два основных этапа работы поисковиков.

Сканирование

Это главное задание бота. При входе на новую страницу робот получает 2 набора данных:

- содержимое, сведения о сервере и служебные данные;

- список ссылок на странице.

Все это направляется дальше на обработку и сохранение. Ссылки, которые попали под сканирование, тоже сохраняются в отдельном разделе «Очередь сканирования». И когда робот добавляет страницу в очередь индексации, а она уже здесь стоит, ей отводится близкое место в очереди. Следовательно, процесс проходит быстрее.

Таким образом, первый эффективный метод ускорить сканирование — нарастить число ссылок на требуемые страницы.

Второй и наиболее простой способ улучшить индексацию — сделать sitemap.xml. Тем самым вы покажете поисковику то, что требуется отсканировать страницы на домене.

Третий способ ускорения индексации — сообщить роботу о дате последних изменений на странице. Для этого бот задействует сведения из заголовка ответа сервера lastmod. Отправить сведения об изменениях получится посредством кода not modify. Для настройки кодов нужно будет запросить помощь веб-разработчика.

Обработка данных

До сохранения сведений в базе они обрабатываются и приводятся в нормальную структуру, что нужно для последующего быстрого поиска. На начальном этапе сервис формирует страницу, учитывая стили, скрипты и т. д. В ходе этого программа видит местонахождение элементов на странице, находит открытые и закрытые для посетителей части, делит страницу на навигацию и контент.

Важный момент. У поискового робота должен быть доступ к css и js. В противном случае он не поймет структуру страницы. Чтобы узнать, есть ли этот доступ, войдите в консоль от «Гугл» — отчет «Посмотреть как Googlebot» — «Сканирование». Здесь выполните проверку страниц ресурса и найдите отличия ее отображения для бота и посетителей.

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса .

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции. Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени

Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа»

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

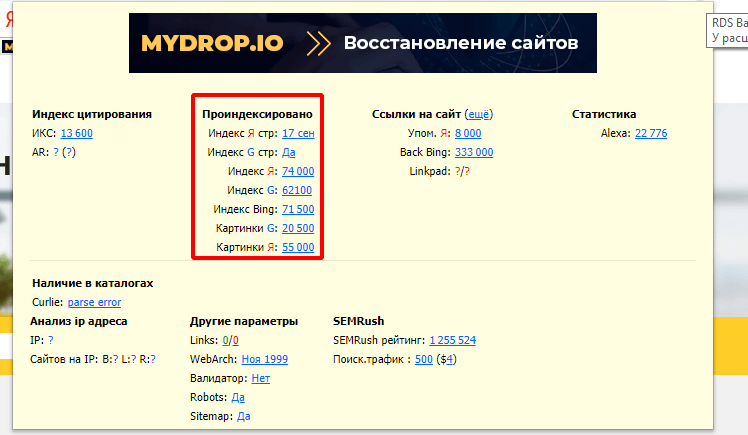

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Как проверить индексацию сайта

Чтобы проверить индексацию сайта в поисковых системах, можно сделать следующее.

Способ 1. Введите в поиске специальный запрос: оператор и адрес сайта (без пробела).

Пример: site:postium.ru.

Актуально, как для Яндекса, так и для Google.

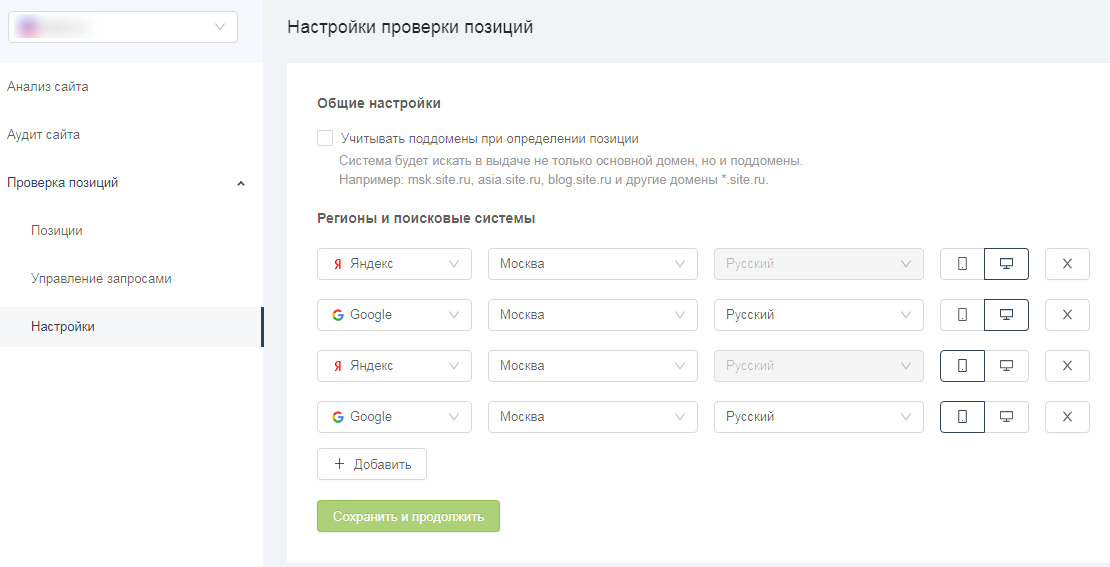

Способ 2: Как узнать сколько страниц проиндексировал Яндекс.

Заходим в Яндекс.Вебмастер и переходим «Индексирование — Структура сайта». Напротив своего сайта, в столбце «В поиске» вы увидите количество проиндексированных страниц.

Способ 3: Как узнать сколько страниц проиндексировал Google.

Заходим в Search Console и открываем раздел «Покрытие». Здесь также показывается количество проиндексированных страниц, и страницы с ошибками.

Способ 4. Расширения для браузера, такой как, например RDS-бар.

Способ 5. Различные SEO-сервисы для анализа сайтов: Serpstat, Netpeak Checker, Pr-cy и прочие.

Заключение

После успешной индексации сайта в поисковых системах, работа не заканчивается. Необходимо периодически делать анализ индексации сайт, а так же снимать позиции по популярным запросам. Это позволит держать руку на пульсе и не оказаться в ситуации, когда значительная часть трафика из поисковиков просто исчезла.

Полезные ссылки:

- Виды поисковых запросов

- Как удержать пользователя на сайте?

- 10 лучших бирж для покупки ссылок

- Как работают поисковые системы

Как сделать индексацию быстрее?

Естественно, любой вебмастер желает, чтобы роботы как можно скорее проиндексировали их сайт, ведь от этого зависит, насколько быстро содержащийся в нем материал появится в поисковой выдаче, который и привлечет новых посетителей. Чтобы индексация прошла быстрее, стоит следовать таким рекомендациям:

- Добавить проект в поисковую систему.

- Постоянно пополнять сайт новым уникальным, информативным и полезным для целевой аудитории контентом.

- Разместить проект на надежном и скоростном хостинге.

- Создать удобную навигацию по ресурсу, доступ на страницы должен быть не больше 3 кликов от главной.

- Правильно настроить файл robots.txt, а именно: заблокировать индексацию служебных страниц и убрать лишние запреты.

- Проверить количество ключевиков, устранить ошибки в исходном коде.

- Обеспечить внутреннюю перелинковку (соединить страницы сайта между собой ссылками).

- Создать карту сайта. Можно даже сделать карту сайта отдельно для роботов и для посетителей.

- Разместить ссылки на статьи портала в соц.сетях.

Как сделать так, чтобы Google индексировал обратные ссылки быстрее

Волшебной кнопки для быстрой индексации в Гугле и других поисковиках не существует. Чтобы нажать её и бэклинки моментально попали в индекс. Но есть рекомендации, которые повышают шансы на успешное индексирование.

Окончательное решение остаётся за алгоритмами. Если они посчитают бэклинк подозрительным или у донора будут активные санкции, ссылки могут не появиться в консолях для вебмастеров.

Убедитесь, что сайт доступен для сканирования

Часто проблемы с индексированием связаны с тем, что роботы не могут получить содержимое страниц. Сайт недоступен из-за плохого хостинга, есть ошибки в конфигурационных файлах или неправильно настроен SEO-плагин.

Самый простой способ проверить доступность для поисковых краулеров — использовать соответствующие инструменты в консолях для вебмастеров. «Переобход» в Яндекс.Вебмастер и «Проверка URL» в Google Search Console.

Добавьте сайт в Google Search Console

Для разбавления ссылочного профиля оптимизаторы часто размещают ссылки не только на старых сайтах, а и на новых проектах. Прежде чем переводить деньги за бэклинк, не забудьте проверить индексацию донора.

Сразу после добавления проекта в GSC, он становится в очередь и через некоторое время роботы обходят страницы. Обычно данные обновляются в течение пары дней, но иногда процесс может занять и недели.

Создайте файл Sitemap

Карта сайта сообщает роботам поисковиков, какие страницы надо обойти. Они считывают дату обновления из файла и понимают, что контент обновился. Если у донора нет карты сайта и новые статьи появляются нечасто, индексация бэклинка может затянуться.

Страница, на которой размещена обратная ссылка, обязательно должна присутствовать в Sitemap. Если вебмастер не следит за этим, проверьте файл и напишите ему с просьбой добавить страницу вручную или обновить список через плагин.

Проверьте robots.txt

Поисковые системы часто игнорируют директивы из технического файла, но иногда страницы с бэклинками не попадают в выдачу из-за ограничений в robots.txt. Гугл и Яндекс давно рекомендуют использовать meta robots, но некоторые вебмастера используют старые методы запрета индексации.

При размещении ссылок на сторонних сайтах доступа к консолям для вебмастеров нет, поэтому для проверки доступности страницы приходится использовать сторонние инструменты. Решить задачу можно с помощью Tools.discript.ru или аналога.

Мониторьте обратные ссылки вручную

При размещении бэклинков через ссылочные биржи можно отслеживать индексацию в одном интерфейсе. Если линк со временем отвалится или выпадет из индекса через несколько дней, можно заказать повторное размещение. Например, при заказе крауд ссылок через нашу биржу Referr, вы сразу в интерфейсе будете видеть новые ссылки и мониторить вручную, чтобы они были доступны.

При работе с вебмастерами напрямую приходится контролировать все самостоятельно. Владелец проекта получает деньги, размещает бэклинк и забывает о вашем существовании.

Усильте ссылки бэклинками

Чем больше упоминаний о важной странице с бэклинком, тем лучше. Тратить много денег на усиление чужого сайта не стоит, но несколько ссылок точно не помешают

В ваших интересах, чтобы инвестиции в линкбилдинг быстрее дали плоды.

Проставляйте линки на свежих страницах

При размещении ссылок через ссылочные биржи вебмастера часто размещают статьи оптимизаторов или заказывают свои. Не секрет, что такой контент очень низкого качества и бэклинки часто вставлены не по смыслу.

Старайтесь подбирать релевантные ресурсы и попросите владельца сайта разместить бэклинк на свежей странице. Или хотя бы немного изменить контент старой статьи и отправить её на переобход.

Проверьте наличие быстробота

У сайтов с новостным контентом и ресурсов, которые обновляются несколько раз в день, обычно нет проблем с индексацией. Ссылки с таких проектов поисковики быстро обнаруживают и если они пройдут проверку, бэклинки появятся в консолях.

Введите адрес сайта в поисковую выдачу, отфильтруйте результаты за день или неделю и посмотрите, как часто появляются новые страницы. Если на сайте есть «прикормленный» быстробот, на нем можно размещаться.

Чего делать точно не стоит?

Некоторые «умные» веб-мастера прибегают к использованию черных и серых инструментов SEO. В частности, они закупают тысячами ссылки, накручивают поведенческие факторы, размещают гостевые статьи и посты (Google за это сейчас наказывает!), распространяют спам на форумах и чужих блогах с ссылками на портал, размещают невидимые ссылки и ключевые слова на страницах своего сайта, автоматически создают большое количество видеороликов для его раскрутки и делают автоматический обмен ссылками. Если вы хотите, чтобы ваш сайт долго жил и индексировался поисковиками, никогда ничего не делайте из вышеперечисленного. Иначе бана и попадания под фильтры не избежать.

Что делать, если сайт плохо индексируется?

Сперва узнайте, закрыт ли сайт от индексации. Это доступно через Google Search Console. Сначала скопируйте урл страницы, перейдите в инструмент и в поле «Проверка URL на ресурсе» вставьте адрес.

В итоге у вас на руках будут данные о запрете индексации

Если обнаружили закрытые страницы, которые уже пора отправить на индексацию, дайте к ним доступ.

Далее можете воспользоваться такими советами:

- создайте карту сайта и добавьте в инструменты для вебмастеров;

- наполните новым контентом или уберите полностью пустые страницы;

- добавьте внешние ссылки с внешних ресурсов.

Упоминалось, что на индексирование влияют многие факторы. Пройдитесь по ним, если видите проблемы с процессом. Но не забывайте о том, что все это занимает время, и ждать, что индексация сайта в поисковых системах будет чрезмерно быстрой, не стоит.

Плюсы и минусы службы индексирования файлов

Минус один – практически постоянная запись данных в индексный файл о месте расположения других файлов может действительно замедлить работу компьютера. На дисках SSD индексация файлов тоже не нужна – твердотельные накопители сами по себе работают гораздо быстрее классических жёстких дисков, так что поиск будет быстрым и без индексации. А вот постоянная запись для SSD вредна, ведь у них имеется ограничение на количество таких операций в жизненном цикле.

Достоинство тоже одно: ускорение поиска при использовании встроенных средств Windows, он становится немного интеллектуальным и в состоянии как бы предугадывать ваши намерения.

Как Гугл и Яндекс проверяют страницы на качество

Чтобы сайты прошли индексацию, о них нужно рассказать. Делается это двумя методами:

- Оставить ссылку на схожих по тематике сайтах. Это самый приемлемый вариант, ведь если информация о портале будет содержаться на других платформах, то боты посчитают его полезным и быстрее проиндексируют: от 12 часов до 2 недель.

- Заполнить специальную анкету, используя инструменты Яндекс.Вебмастер, Google Webmaster Tools и другие. Индексация здесь происходит медленнее, так как ресурс находится в очереди и может простоять в ней от 2 недель и больше.

Seo-специалисты считают, что Гугл справляется со своей задачей значительно быстрее, так как эта поисковая система индексирует страницы без разбора: как полезные, так и бесполезные. Тем не менее ранжируются только качественные сайты.

С другой стороны, Яндекс работает медленнее, но лучше отбирает ресурсы, содержащие полезный контент, отсеивая “мусор”.

Как происходит индексация:

- поисковый бот заходит на сайт и анализирует его содержимое;

- все данные вносятся в базу данных;

- приблизительно через 2 недели информация, которая прошла индексацию, появляется в выдаче.

Отличия индексации сайта от сканирования

Итак, мы разобрались, что такое индексация сайта в поисковых системах. Однако также существует термин «сканирование». Это не индексация страниц, а перемещение робота от одной страницы к другой.

Термин «сrawling» означает отправку бота на анализируемый сайт, индексирование — это процесс загрузки, обработки и сбора данных, после которого ресурс включается в индекс поисковой системы. Что касается сканирования, оно не означает, что адрес сайта был проиндексирован и будет выдаваться пользователям как результат их поисковых запросов.

Веб-адрес размещается в индексе после сканирования. Не каждая просканированная страница оказывается в индексе, но каждая проиндексированная изначально сканировалась.

Краулинговым бюджетом называется максимальный объем данных, которые поисковая система получает с домена в результате посещения роботом. Чтобы этот объем данных оказался как можно больше, нужно учесть два аспекта:

- ограничение скорости сканирования;

- ускорение индексирования сайта.

Поисковые роботы стремятся за одно посещение сайта просканировать как можно больше URL-адресов. Если скорость сканирования ограничена, они делают обход без перегруза сервера. Если же краулер будет загружать слишком большое количество страниц одновременно, сайт будет грузиться слишком долго. Пользователи могут просто уйти, не дождавшись окончания этого процесса.

Чтобы ограничить скорость сканирования, ранее указывали директиву crawl-delay в файле robots.txt. На данный момент она является устаревшей, потому что поисковые системы сами контролируют скорость. При слишком серьезной нагрузке на сервер сканирование прекращается автоматически. Если ваш веб-ресурс слишком много «весит», нужно оптимизировать его. Это позволит роботам тратить меньше времени и осуществлять полное сканирование.

Ускорить процесс поисковой индексации сайта можно, принудительно вернув робота на сайт. Как это делается? Обновленные страницы перенаправляются на повторное сканирование через панель веб-мастера. Имейте в виду, что сайты с высокой посещаемостью и ресурсы, где регулярно обновляется контент, обрабатываются чаще. Поисковые роботы замечают изменения и проводят работу. А прекращение работ по оптимизации ресурса приводит к понижению его позиции в выдаче.

Бюджетом индексации сайта называют число URL-адресов, которые поисковая система может и хочет проиндексировать. Единица его измерения — мегабайт (Мб).

Каждый домен имеет свой ежедневный бюджет. Когда он израсходован, боты прекращают индексирование сайта. Далее они проверяют обновления на уже загруженных адресах. Если сайт имеет некачественную структуру, некоторые его страницы могут вообще не индексироваться. При разработке сайта стоит в первую очередь думать не о его привлекательном виде, а об удобстве для пользователей с учетом дальнейшей оптимизации. Важные дочерние страницы должны иметь приоритет в иерархии структуры ресурса. Тогда индексация сайта в поисковых системах будет происходить должным образом.

Неизвестно, когда именно поисковый робот повторно придет на сайт, когда именно он прекращает сканирование и когда возвращается к нему.

Индексирование сайта происходит циклично. Вам следует регулярно обновлять контент, если вы хотите, чтобы ресурс занимал высокие позиции в результатах выдачи. После первого посещения роботы периодически наносят повторные визиты с целью проверить и проиндексировать изменения. Если они часто обнаруживают на вашем ресурсе полезный и актуальный контент, то будут возвращаться снова. И чем раньше сайт пройдет индексацию, тем скорее он появится в результатах поисковой выдачи.

Типы роботов поисковых систем

Процессы поисковых систем основаны на работе четырех типов основных поисковых роботов:

- Основной индексирующий робот;

- Робот, индексирующий изображения;

- Робот, изучающий зеркала сайта;

- Робот, контролирующий работоспособность страниц сайта и сайта в целом.

Вы можете контролировать, вернее, быть в курсе, какой робот зашел к вам на сайт. Для этого есть специальные лог-файлы посещений. Доступны эти файлы в административной панели сервера (хостинга) или по FTP. Например,

- Основной индексирующий робот Яндекс: YandexBot/3.0; +http://yandex.com/bots;

- Бот Mail: Mail.RU_Bot/2.0; +http://go.mail.ru/help/robots.

- В журнале посещений, вы увидите боты в таком обозначении: «Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) – это бот Bing.

Кроме четырех перечисленных , выше, типов роботов, есть и другие индексирующие роботы:

- Индексирующие видео и иконки (пиктограммы) сайтов;

- Робот, контролирующий доступность (работоспособность) сайтов;

- Индексатор «быстрой» информации, на новостных площадках Яндекс. Новостей и т.п.

На этом все! Эта небольшая статья, не может охватить все детали, и процессы поисковых систем требует более глубокого изучения.

SeoJus.ru

Что такое индексация сайта?

Роботы поисковой системы заходят на сайт, изучают его контент, вносят ресурс в базу данных — этот процесс и называется индексированием. После того, как платформа была одобрена, информация, содержащаяся на его страницах, выдается по ключевым запросам. То есть, когда пользователь вводит в поисковую строку запрос, то он получает список сайтов, прошедших индексацию.

Попробуем объяснить простыми словами что такое индексация сайта. Представьте, что Интернет — это большое хранилище книг. Чтобы без труда можно было найти нужный экземпляр, составляется каталог. В 90-х гг 20 века индексация была схожа с такими перечнями объектов. Поисковые роботы искали ключи на страницах и создавали на их основе базу данных.

В том случае, если сервер не проиндексирован, то информация, размещенная на нем, может и не открыться юзерам.

Правильные шаги оптимизации сайта

Шаг № 1. Добавьте ваш блог в сервисы для вебмастеров

Для Яндекса это сервис «Яндекс.Вебмастер». Вам нужно либо зарегистрироваться, либо зайти под своим логином и паролем, если у вас есть уже аккаунт на Яндексе.

Далее нужно добавить в этот сервис свой сайт через специальную форму.

После добавления адреса вам нужно будет подтвердить права на его владение, а именно скачав специальный файл от сервиса и разместив его в папке с вашим сайтом на хостинге. В самом сервисе приводится подробное объяснение, думаю, разберетесь.

Для Google это сервис «Инструменты для Вебмастеров». Почти все то же самое. Регистрируетесь или входите через аккаунт Google, если он у вас есть, добавляете сайт и подтверждаете права на него.

Добавление блога в эти сервисы сообщает поисковикам, что у вас есть сайт и пора обратить на него внимание

Также вы сможете увидеть, сколько страниц попало в индекс, сколько не попало, что это за страницы, какие ошибки были при сканировании, ну и еще много полезной информации.

Шаг № 2. Создание файла Sitemap.xml

Так называемая карта сайта. Для этого существуют специальные плагины, которые автоматически такую карту генерируют. Например, если блог на MaxSite CMS, обычно используют стандартный плагин «xml_sitemap».

Если у вас блог на каком-то другом движке, то набираете в поисковики «плагин для генерации sitemap для X», где вместо X поставить название вашего движка. Уверен, что-то обязательно найдете.

Если вы все установите правильно, то по адресу вашсайт.ru/sitemap.xml появится карта сайта. Ну бывают исключения, в зависимости от движка, что адрес карты сайта другой, но, в основном, так.

Шаг № 3. Добавление файла Sitemap в сервисы для вебмастеров

В сервисах, о которых мы говорили выше, есть возможность добавить адрес карты Sitemap вашего сайта.

В сервисе Яндекса нужно выбрать в левом меню «Настройки индексирования» — «Файлы Sitemap» — «Добавить».

В сервисе от Google выбрать в левом меню «Сканирование» — «Файлы Sitemap» — «Добавить».

В файле Sitemap приведены все (или почти все) страницы вашего блога, поэтому, когда поисковики загрузят данный файл к себе, то ваш сайт проиндексируется довольно быстро.

Шаг № 4. Делаем ссылку в меню блога «Архив статей»

По умолчанию, такая ссылка есть на любом блоге, поэтому просто её не убирайте. По сути, это та же карта сайта, только в привычном для нашего глаза формате

Это тоже позволит поисковикам довольно быстро индексировать ваш блог.

Шаг № 5. Сделайте RSS ленту вашего блога и добавьте её в каталоги RSS

Для создания RSS с возможностью подписки на новости рекомендую воспользоваться сервисом FeedBurner от Google.

После настройки RSS ленты желательно добавить её адрес в каталоги RSS. Где искать эти каталоги? Да очень просто, вбиваете в поисковике «добавить RSS» или «RSS каталог» и добавляете туда свою ленту.

Шаг № 6. Поставьте везде в соц.аккаунтах ссылку на ваш блог

По любому, вы где-то зарегистрированы: Вконтакте, Facebook, Google+, Twitter, Одноклассники и т.п. Так вот, везде есть поле «Сайт», куда нужно добавить свой сайт.

Если у вас несколько аккаунтов в разных соц.сетях, то нужно написать адрес вашего сайта в каждый из них. На сайтах соц.сетей поисковые роботы буквально живут. Поэтому, все что туда попадает, довольно быстро индексируется.

Шаг № 7. Добавляйте адрес вашего блога везде, где только можно

Я не имею в виду специально спамить все попавшие под руку каталоги и сайты. Но возьмите за правило: если вы где-то регистрируетесь и видите поле «Сайт», которое можно заполнить, то это поле не должно остаться пустым.

Регистрируетесь где-то, – укажите сайт, оставляете комментарий на каком-то блоге – там тоже это поле есть. Чем больше адрес вашего сайта светится по Интернету, тем лучше индексация вашего сайта.

Но это еще не все… Здесь я рассказал вам, по сути, разовые способы, которые один раз настроил и они работают. Данные способы помогают заявить о вашем сайте поисковым системам, чтобы они начали его индексировать ну и ускорить индексацию вашего блога в целом в несколько раз.

Но, чтобы добиться действительно быстрой индексации ваших статей, нужно выполнять определенные ритуалы при добавлении каждой статьи.

Например, данные ритуалы помогают загнать страницу в индекс Яндекса и Google в течение 1 дня после её выпуска, порой даже быстрее.

Проверка индексации с помощью операторов URL и SITE

Пожалуй, этот способ является самым лучшим. Можно в адресную строку браузера или поиск ввести запрос и при необходимости нажимать F5, чтобы следить, как обновляется информация. В одном окне также можно ввести несколько запросов подряд, обновлять страницу или нажимать Назад/Вперед и отслеживать изменения.

Как узнать проиндексирован ли сайт в Яндекс? Для этого необходимо воспользоваться оператором URL. Данный сервис также используется для Bing и Рамблера.

Для проверки индексации в Google используется оператор SITE. Используется код site:site.ru, где site.ru – это адрес сайта, на котором расположена необходимая страница.

Также в адресную строку Яндекса можно ввести http://yandex.ru/yandsearch?serverurl= и далее адрес той страницы, которая вас интересует.

UPD: На данный момент рекомендуется использовать запрос типа https://yandex.ru/search/?text=url%3Awww.host.ru%2F*

Отметим, что этот способ подобен использованию расширенного поиска с тем лишь отличием, что в данном случае метод более автоматизирован и нет необходимости еще куда-то заходить. Следует знать о том, что иногда могут возникать некоторые неточности в поисковых системах, если в поиск вводится зеркало сайта. Но это, в принципе, теоретически.

Теперь нужно уточнить кое-какие вопросы относительно быстробота. В Яндексе он есть. Его задача заключается в том, чтобы как можно быстрее проиндексировать страницы. Он посещает сайты, отмечает новый контент и уходит. Через какое-то время за ним приходит основной поисковый бот, который и выполняет анализ, классифицирует и расставляет по своим местам материалы. Бывает, что быстробот проиндексирует, а Яндекс потом выбрасывает контент из индекса.

В поисковой выдаче возле каждой ссылки указывается время проведения индексации. Редко возможны случаи, когда какие бы способы проверки индексации сайта не применялись, а найти его не удается, но через какое-то время статья появляется в индексе и указано время ее индексации, скажем 18 часов назад.

Что такое индексация обратных ссылок

Индексация обратных ссылок — процесс добавления их в базу поисковых систем. Когда роботы Яндекса и Гугла обнаруживают новый контент, они сканируют его и через некоторое время страница появляется в выдаче.

Несколько лет назад поисковики индексировали контент гораздо медленнее, чем сейчас. Особенно ярко выраженной проблема была в Яндексе. Вебмастера неделями ждали апдейтов, чтобы новые страницы попали в базу поисковой системы и начали набирать вес.

В 2021 году таких проблем нет — если сайт хорошо оптимизирован по технической части и регулярно публикует контент, новые адреса быстро попадают сначала в быструю выдачу, а затем в основную.

С бэклинками не все так просто — они индексируются гораздо дольше. При покупке ссылок напрямую есть риск остаться ни с чем. К примеру, если на сайте вебмастера проблемы с файлом robots.txt или неправильно настроен тег meta robots, ничего сделать не получится. Придется ждать, пока владелец проекта выйти на связь и разберется с ошибками.

Проблемы с индексацией ссылок на авторитетных сайтах возникают редко. Если контент регулярно обновляется и быстробот добавляет новые страницы в индекс, Google и Яндекс быстро обнаруживают проставленные ссылки и индексируют их.

Скорость появления бэклинков в консолях для вебмастеров зависит от многих факторов, поэтому нельзя однозначно сказать, когда ссылка начнет учитываться поисковиками. При наличии технических проблем у поисковых систем процесс обновления ссылочного профиля может затянуться надолго.

Часто бывает так, что при проверке сторонними сервисами находится гораздо больше бэклинков, чем в Google Search Console и Яндекс.Вебмастер. Это нормальная ситуация, но линки с основных ресурсов должны быть видны во всех источниках.

Факторы, которые влияют на индексацию ссылок

Опытные SEO-специалисты и вебмастера знают главное правило линкбилдинга: «Ссылки с трастовых и релевантных ресурсов на вес золота». Обычно с такими бэклинками не возникают проблемы, они быстро индексируются и приносят профит в виде хороших позиций. Особенно важна скорость индексации обратных ссылок при продвижении новых сайтов.

Что касается появления ссылки в консолях для вебмастеров, то данные могут обновляться с задержкой. Часто бэклинки пропадают из списка, а потом снова появляются. Это естественный процесс, на нём не стоит зацикливаться.

Факторы, влияющие на индексацию ссылок:

- Качество донора. Чем авторитетнее сайт в глазах поисковых систем, тем быстрее индексируются страницы и обратные ссылки. Как же проверить качество и траст донора, читайте в статье.

- Правильность размещения. Неактивные ссылки и URL, ссылающиеся на неосновное зеркало, могут не появиться в консолях для вебмастеров.

- Частота обновления контента. Ссылки с новостных проектов и других ресурсов с непрерывным процессом обновления информации индексируются гораздо быстрее.

- Техническое состояние. Если сайт часто падает, некорректно настроены каноникалы или страницы отдают неправильный код, могут возникнуть проблемы с попаданием линков в базу поисковых систем.

- Стабильность поисковиков. При глобальных обновлениях алгоритмов или масштабных изменениях в Google Search Console или Яндекс.Вебмастер новый контент может индексироваться с задержкой.

Если закупаете ссылки на качественных проектах и придерживаетесь четкого плана по линкбилдингу, проблем с индексацией и учетом бэклинков не будет. Следите за ситуацией, но в разумных пределах. Нет смысла несколько раз в день заходить в консоли для вебмастеров и обновлять страницу с внешними ссылками.

Что такое индексация сайта в поисковых системах?

Можно провести Google Аналитику, что это такое Google Аналитика, мы уже знаем.

Для этого нужно добавить ссылку на сайт на других ресурсах. Именно такие сайты быстрее всего индексируют поисковые системы. Можно индексировать сайт если отправить для этого форму, которую предлагает заполнить поисковая система.

В данном случае индексация будет проходить немного медленнее и может занять более двух недель. В первом случае индексация может пройти в течение двенадцать часов. Даже не смотря на то, что проходит индексация для полезных и не полезных ресурсов, попадает для ранжирования только качественный контент.

Такой способ использует Гугл, именно поэтому индексация здесь проходит быстрее. Яндекс делает это медленнее, но он сразу исключает страницы-мусор, в Яндекс можно использовать настройку рекламной кампании в яндекс директ, использование которой дает хороший результат.

Заключение

Как видите, правильно настроить индексирование сайта в поисковых системах не так уж и просто. Постоянно могут возникнуть проблемы, связанные, как с человеческим фактором, так и техническим. Также следует учесть и время, необходимое для индексации, которое может длиться от 2 недель до трех месяцев, в зависимости от сложности ситуации.

Во избежание неправильной настройки индексирования (особенно, если Вы мало разбираетесь в технических аспектах и нюансах), рекомендуем обратиться напрямую к специалистам в данной области или в специализированное веб-агентство, в штате которого такие профессионалы присутствуют.

поисковая оптимизация

индексирование

техническая оптимизация