Что такое индексация сайта в поисковых системах: как проверить и ускорить индексирование страниц

Содержание:

- Индексация страниц сайта в Яндекс Вебмастер

- Что такое индексация обратных ссылок

- Как эффективно проиндексировать сайт

- Способы по ускорению индексации сайта

- Robots.txt

- Проверка индексации страниц сайта через поиск

- Как ускорить индексацию сайта в поисковых системах

- По поводу Вебмастера

- Как управлять поисковым роботом

Индексация страниц сайта в Яндекс Вебмастер

Статистика обхода в Яндекс Вебмастер

Для начала зайдем в пункт «Статистика обхода». Раздел позволяет узнать, какие страницы вашего сайта обходит робот. Вы можете выявить адреса, которые робот не смог загрузить из-за недоступности сервера, на котором находится сайт, или из-за ошибок в содержимом самих страниц.

Раздел содержит информацию о страницах:

- новые – страницы, которые недавно появились на сайте либо робот их только что обошел;

- изменившиеся – страницы, который поисковик Яндекса раньше видел, но они изменились;

- история обхода – количество страниц, которые обошел Яндекс с учетом кода ответа сервера (200, 301, 404 и прочие).

На графике отражены новые (зеленый цвет) и изменившиеся (синий цвет) страницы.

А это график истории обхода.

В этом пункте отображены страницы, которые Яндекс нашел.

N/a – URL не известен роботу, т.е. робот её раньше не встречал.

Какие выводы из скрина можно сделать:

- Яндекс не нашел адрес /xenforo/xenforostyles/, что, собственно, логично, т.к. этой страницы больше нет.

- Яндекс нашел адрес /bystrye-ssylki-v-yandex-webmaster/, что тоже вполне логично, т.к. страница новая.

Итак, в моем случае в Яндекс Вебмастере отражено то, что я и ожидал увидеть: что не надо – Яндекс удалил, а что надо – Яндекс добавил. Значит с обходом все у меня хорошо, блокировок никаких нет.

Страницы в поиске

Поисковая выдача постоянно меняется – добавляются новые сайты, удаляются старые, корректируются места в выдаче и так далее.

Информацию в разделе «Страницы в поиске» вы можете использовать:

- для отслеживания изменений количества страниц в Яндексе;

- для слежения за добавленными и исключенными страницами;

- для выяснения причин исключения сайта из поисковой выдачи;

- для получения информации о дате посещения сайта поисковиком;

- для получения информации об изменении поисковой выдачи.

Чтобы проверить индексацию страниц и нужен этот раздел. Здесь Яндекс Вебмастер показывает страницы, добавленные в поисковую выдачу. Если все ваши страницы добавлены в раздел (новый добавятся в течение недели), то значит со страницами все в порядке.

Что такое индексация обратных ссылок

Индексация обратных ссылок — процесс добавления их в базу поисковых систем. Когда роботы Яндекса и Гугла обнаруживают новый контент, они сканируют его и через некоторое время страница появляется в выдаче.

Несколько лет назад поисковики индексировали контент гораздо медленнее, чем сейчас. Особенно ярко выраженной проблема была в Яндексе. Вебмастера неделями ждали апдейтов, чтобы новые страницы попали в базу поисковой системы и начали набирать вес.

В 2021 году таких проблем нет — если сайт хорошо оптимизирован по технической части и регулярно публикует контент, новые адреса быстро попадают сначала в быструю выдачу, а затем в основную.

С бэклинками не все так просто — они индексируются гораздо дольше. При покупке ссылок напрямую есть риск остаться ни с чем. К примеру, если на сайте вебмастера проблемы с файлом robots.txt или неправильно настроен тег meta robots, ничего сделать не получится. Придется ждать, пока владелец проекта выйти на связь и разберется с ошибками.

Проблемы с индексацией ссылок на авторитетных сайтах возникают редко. Если контент регулярно обновляется и быстробот добавляет новые страницы в индекс, Google и Яндекс быстро обнаруживают проставленные ссылки и индексируют их.

Скорость появления бэклинков в консолях для вебмастеров зависит от многих факторов, поэтому нельзя однозначно сказать, когда ссылка начнет учитываться поисковиками. При наличии технических проблем у поисковых систем процесс обновления ссылочного профиля может затянуться надолго.

Часто бывает так, что при проверке сторонними сервисами находится гораздо больше бэклинков, чем в Google Search Console и Яндекс.Вебмастер. Это нормальная ситуация, но линки с основных ресурсов должны быть видны во всех источниках.

Факторы, которые влияют на индексацию ссылок

Опытные SEO-специалисты и вебмастера знают главное правило линкбилдинга: «Ссылки с трастовых и релевантных ресурсов на вес золота». Обычно с такими бэклинками не возникают проблемы, они быстро индексируются и приносят профит в виде хороших позиций. Особенно важна скорость индексации обратных ссылок при продвижении новых сайтов.

Что касается появления ссылки в консолях для вебмастеров, то данные могут обновляться с задержкой. Часто бэклинки пропадают из списка, а потом снова появляются. Это естественный процесс, на нём не стоит зацикливаться.

Факторы, влияющие на индексацию ссылок:

- Качество донора. Чем авторитетнее сайт в глазах поисковых систем, тем быстрее индексируются страницы и обратные ссылки. Как же проверить качество и траст донора, читайте в статье.

- Правильность размещения. Неактивные ссылки и URL, ссылающиеся на неосновное зеркало, могут не появиться в консолях для вебмастеров.

- Частота обновления контента. Ссылки с новостных проектов и других ресурсов с непрерывным процессом обновления информации индексируются гораздо быстрее.

- Техническое состояние. Если сайт часто падает, некорректно настроены каноникалы или страницы отдают неправильный код, могут возникнуть проблемы с попаданием линков в базу поисковых систем.

- Стабильность поисковиков. При глобальных обновлениях алгоритмов или масштабных изменениях в Google Search Console или Яндекс.Вебмастер новый контент может индексироваться с задержкой.

Если закупаете ссылки на качественных проектах и придерживаетесь четкого плана по линкбилдингу, проблем с индексацией и учетом бэклинков не будет. Следите за ситуацией, но в разумных пределах. Нет смысла несколько раз в день заходить в консоли для вебмастеров и обновлять страницу с внешними ссылками.

Как эффективно проиндексировать сайт

Чтобы сайт как можно быстрее начали индексировать поисковые системы, его надо добавить в базу поисковиков через инструменты для вебмастеров.

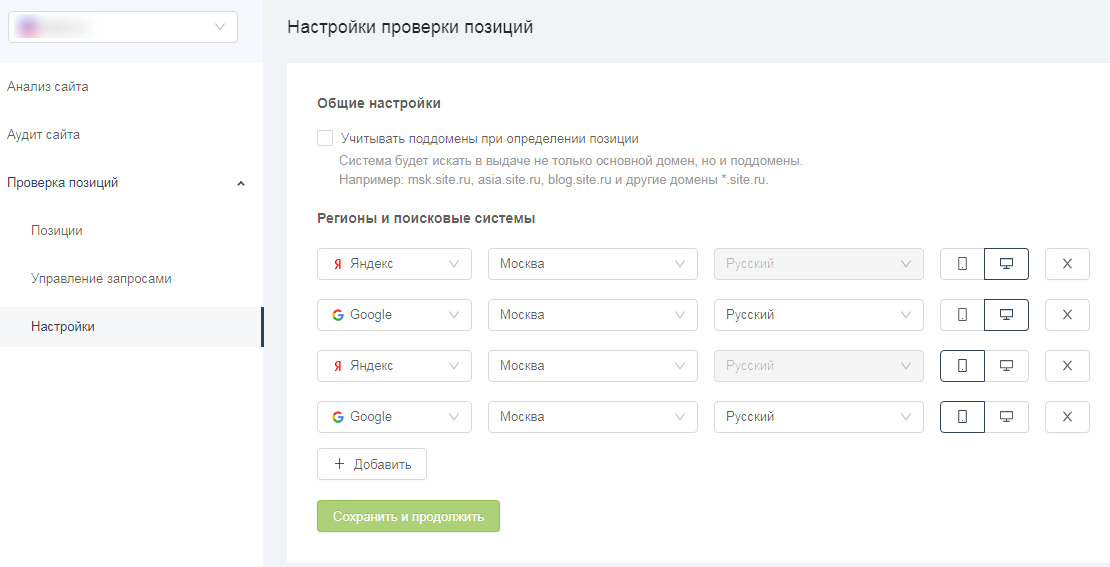

Добавьте сайт в Яндекс.Вебмастер

Простой ответ на вопрос «Как проиндексировать сайт в Яндексе?» — добавить его в Вебмастер.

Для начала, заведите личный кабинет в сервисе и добавьте сайт в главном меню по адресу https://webmaster.yandex.ru/sites/add/.

На следующем шаге скопируйте код подтверждения и добавьте его в исходный код главной страницы сайта в раздел <head>.

Для повышения точности данных привяжите Яндекс.Метрику к сайту в пункте Настройки -> Привязка к Яндекс.Метрике. Информацию из Метрики робот будет использовать при обходах.

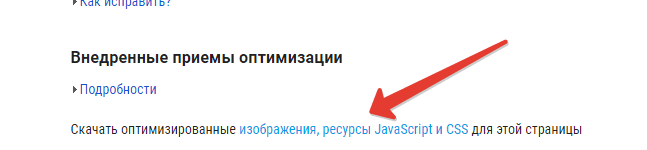

Чтобы проверить, проиндексированы ли какие-то страницы на текущий момент, перейдите в меню Индексирование -> Проверить статус URL.

В том же меню есть информация о том, когда и с каким результатом робот обходил страницы, какие из них есть в поиске, а также функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

Добавьте сайт в Google Search Console

Перейдите на https://search.google.com/search-console/welcome и войдите в учётную запись. Добавьте сайт в систему.

Как и в Яндекс.Вебмастере, инструмент предлагает множество отчётов о состоянии индексации сайта. Вы может увидеть, какие страницы проиндексированы и добавлены в поиск, внутренние и внешние ссылки и многое другое.

При этом, если Яндекс автоматически обнаруживает файлы Sitemap и имеет гибкие настройки переиндексации, то у Google Search Console с этим возникнуть проблемы. Иногда он не может найти файлы Sitemap и их обязательно нужно загрузить вручную. Настройки повторного обхода страниц после обновлений не так удобны — сперва необходимо проверить конкретный URL, а лишь затем появится кнопка Запросить индексирование.

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем помимо Яндекса и Google стремится к нулю. Тем не менее, не следует ими пренебрегать, если сайт является важным имиджевым элементом крупного проекта или организации.

Рамблер

Рамблер основан на тех же данных индексации, которые собирает Яндекс — в этом случае нет необходимости в дополнительных настройках.

Mail.ru

Mail.ru, в свою очередь, пока располагает своим кабинетом для вебмастеров https://webmaster.mail.ru/. В нём предусмотрен минимальный набор управления и отслеживания индексации в системе.

Yahoo.com и Bing

Как ни странно, в определённый момент Bing, принадлежащий Microsoft, поглотил поисковый движок Yahoo, объединив помимо прочего их сервисы для вебмастеров под вывеской https://www.bing.com/toolbox/webmaster/.

Способы по ускорению индексации сайта

Чем быстрее будут проиндексирован контент поисковыми системами, тем быстрее он попадет в поисковую выдачу и тем быстрее его увидят пользователи. О проблемах индексирования вы можете прочитать здесь.

Как ускорить индексирование:

Добавляйте сайт и отдельные страничные данные в поисковые системы через сервисы веб-мастеров — не ждите, пока поисковые роботы сами найдут и проиндексируют их. Например, в Яндекс.Вебмастере предусмотрена функция отправки до 20 ссылок в день на те страничные данные, которые нужно проиндексировать в первую очередь. Если речь идет об индексации всего сайта, то можно сделать следующим образом: добавить его в Google и Яндекс, затем дать поисковым системам ссылку на карту сайта. Скорость попадания в выдачу зависит от разных факторов и может составлять 1-3 недели.

Размещайте ссылки на ваш сайт на других ресурсах

Чем выше в поисковой выдаче находится ресурс со ссылкой, тем быстрее на него обратят внимание поисковые роботы и тем быстрее добавят сайт в индекс. Например, роботами с большой частотой на предмет обновления контента проверяются новостные порталы

Размещение на их страницах вашей ссылки позволит пройти индексацию в течение 1-3 дней.

Регулярно добавляйте и обновляйте контент. Один из методов SEO-продвижения заключается в составлении семантического ядра, охватывающего ключевые запросы по тематике сайта. Постоянное добавление новых страниц с уникальным текстовым и видео контентом, заточенным под ключевые слова семантического ядра, повышают к сайту интерес со стороны поисковых роботов. Чем больше контента, чем лучше он структурирован и чем чаще он обновляется, тем чаще заходят на сайт роботы и тем быстрее проходит индексация.

Перелинковывайте страницы между собой. У внутренней перелинковки есть два плюса. Роботы по внутренним ссылкам быстрее переходят на другие страницы сайта, тем самым быстрее их индексируя. Пользователи, переходя по линкам, посещают большее количество страниц, поднимая сайт в поисковой выдаче.

Задействуйте социальные сети для продвижения нового контента. Добавляйте ссылки, привлекайте на новые страницы пользователей — так вы сможете быстрее привлечь внимание роботов и добавить контент в поиск.

Задача вебмастера — повысить авторитетность сайта в глазах поисковых роботов, оптимизировать контент и ссылки.

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Проверка индексации страниц сайта через поиск

Термином «индексация сайта» обозначают добавление ресурса или его материалов в базу данных поисковой системы. То есть, если страницы сайта проиндексированы, то при введении поискового запроса они окажутся в общей выдаче. Это именно то, чего добиваются вебмастера – чтобы материалы Интернет-ресурсов как можно быстрее оказались проиндексированы.

Чтобы быть уверенными в том, добавлен ли сайт в поисковую базу, выполняется проверка индексации сайта в Яндексе, Гугле и других поисковых системах. Эту проверку можно выполнять как ручным способом, так и автоматически.

Рассмотрим, как проверить проиндексирован ли сайт, используя при этом поисковый запрос. Здесь возможно несколько вариантов:

- Введение url конкретной страницы в поисковый запрос. Этот способ подойдет для тех страниц, которые проиндексированы не быстроботом Яндекса. В противном случае, страница может и не отобразиться, поэтому данный метод проверки малоэффективный.

- Введение части текста в поисковый запрос. Метод действует только тогда, когда текст уникальный. Для этого необходимо выделить часть текста (10-20 слов) и ввести их в поиск. Однако, материал будет достаточно поздно отображаться в выдаче. Этот способ также не очень эффективный и хлопотный.

- Использование расширенного поиска. Чтобы узнать, проиндексирован ли сайт в Яндексе, нужно ввести необходимый запрос в этом поисковике и выполнить поиск, после чего под строкой появится ссылка «Расширенный поиск». Что касается Гугла, то с ним немного дольше придется повозиться. После введения запроса с правой стороны появится знак шестеренки – «Настройки». Нужно нажать этот значок и в меню выбрать пункт «Расширенный поиск». Помимо Яндекса и Гугла другие ПС также располагают расширенным поиском. Итак, дальше нужно ввести фразу и домен, на котором нужно произвести поиск. В выдаче обычно самой первой должна появиться нужная статья. Это работает при условии, что материал уникальный. Можно пойти более быстрым путем и сразу вбить в расширенный поиск url страницы. Данный способ эффективный, но требует временных затрат. Следует учесть, что не всегда нужный адрес находится на первой позиции в поисковой выдаче. Иногда необходимо просмотреть всю первую страницу в выдаче, то есть, топ-10.

Как ускорить индексацию сайта в поисковых системах

Есть несколько

способов:

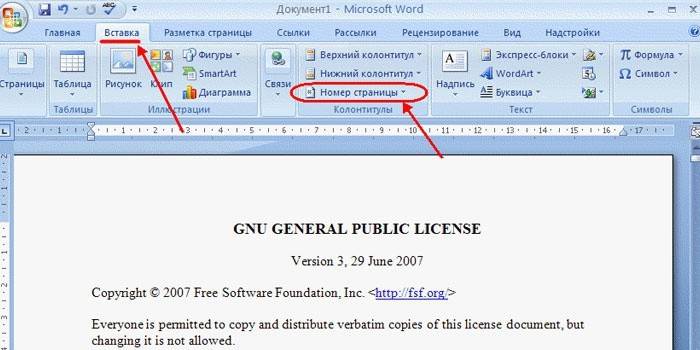

Добавление страницы с помощью Search Console

Это самый быстрый и простой способ

проиндексировать страницу. Обычно он занимает от нескольких секунд до

нескольких минут. По истечении этого времени ваш ресурс станет видимым для Google. Просто вставьте полный адрес страницы для индексации и нажмите запросить

индексацию в специальном окошке.

Добавление страницы в индекс через карты XML

XML-карта разработана для роботов Google. Он должен быть на всех страницах, потому что формат XML значительно упрощает индексацию страницы в Гугл. Карта XML – это совокупность всей информации об URL-адресах и подстраницах ресурса. В XML также содержится вся информация обо всех обновлениях ресурса.

Как только нам удастся создать карту сайта,

добавьте ее в поисковую систему Google. Благодаря этому роботы

будут знать, где найти данную карту сайта с ее данными. Чтобы отправить карту XML в Гугл, используйте Google Search Console. Когда карта будет обработана, вы сможете отображать статистику на

заданной странице и любую полезную информацию об ошибках.

Индексирование с PDF

Все больше и больше компаний решают размещать

на своих сайтах тексты в формате PDF. Если текст находится в

этом формате, Google может обработать изображения для извлечения

текста.

Как обрабатываются ссылки в файлах PDF? Ссылки в PDF обрабатываются точно так

же, как ссылки на веб-страницах. Стоит помнить, что там должны быть размещены

запрещенные для подписки ссылки. Чтобы проверить индексацию файлов PDF, введите фразу в поисковике вместе с аннотацией PDF.

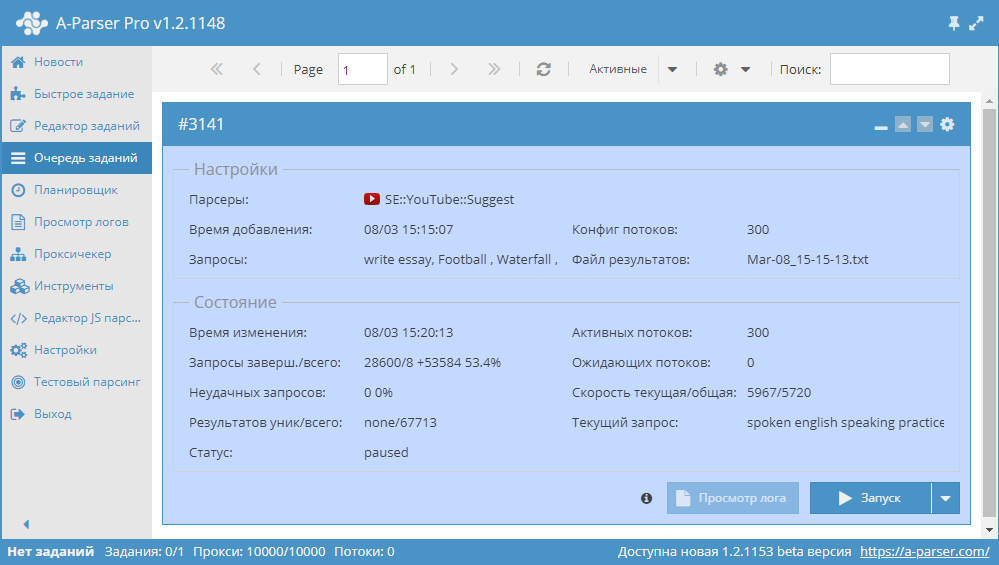

Индексирование веб-сайтов с помощью онлайн-инструментов

Это базовая и очень простая форма индексации.

Это делается через несколько обратных ссылок

Есть много инструментов этого

типа, большинство из них платные или имеют ограниченную бесплатную версию.

Индексирование с помощью онлайн-инструментов важно для ссылок и страниц, к

которым у нас нет доступа. Добавив их в индексацию, Google Robot сможет свободно перемещаться по ним

Бюджет сканирования – это бюджет сканирования

вашего ресурса. В частности, краулинговый бюджет – это количество страниц,

проиндексированных Google на вашем сайте роботами

Гугл за одно посещение.

Это зависит от размера вашего ресурса и его

состояния, т. е. Ошибок, с которыми сталкивается Гугл, и, конечно же, от

количества ссылок на ваш ресурс. Роботы ежедневно индексируют миллиарды под-страниц,

поэтому каждое такое посещение загружает некоторые серверы со стороны владельца

и Google.

На краулинговый бюджет наибольшее влияние

оказывают два параметра:

- Crawl Rate Limit – ограничение скорости индексации страницы;

- Crawl Demand – частота, с которой сайт индексируется.

Crawl Rate Limit это ограничение, введенное для

предотвращения одновременного сканирования слишком большого количества страниц

в Google. Оно было разработано для обеспечения защиты

от возможной перегрузки сайта. Основная цель ограничителя состоит в том, чтобы Гугл

не отправлял слишком много запросов, которые замедлили бы скорость вашего ресурса.

Это также может зависеть от скорости веб-сайта, если она слишком медленная,

замедляется темп всего процесса. Тогда Google сможет проанализировать только некоторые из ваших подстраниц. На

ограничение скорости сканирования также влияет ограничение, установленное в Google Search Console. Владелец сайта может изменить значение лимита через панель.

Требование сканирования основано на

технических ограничениях. Если страница представляет ценность для

потенциального пользователя, робот с большей вероятностью ее посетит. Возможно,

даже если ограничение скорости сканирования не используется, ваш веб-сайт не

будет проиндексирован. На это могут повлиять два фактора:

- популярность, т. е. адреса, которые посещают

большее количество пользователей, чаще посещаются роботами; - актуальность – алгоритмы проверяют, насколько

часто сайт обновляется.

Вывод

Есть много способов проиндексировать страницу

в Google и Яндекс. Самые популярные из них:

- добавление страницы в Яндекс Вебмастер;

- индексация с помощью Search Console;

- карты XML;

- индексирование файлов PDF;

- индексация веб-сайтов с помощью

онлайн-инструментов.

Любой владелиц ресурса, если он хочет

добиться успешного развития своего ресурса, должен работать над его оптимизацией под поисковые системы. Это наиболее

верный способ сделать сайт более популярным и увеличить доход от рекламы. Для

успеха в деле оптимизации лучше всего обратится к профессионалам, которые помогут устранить все препятствия на пути популяризации

Интернет-ресурса.

По поводу Вебмастера

Как Вы успели заметить, в некоторых примерах, мы обращались к сервису, где можно пронаблюдать за различными моментами, касающимися динамики индексирования сайта в поиске. Так как мы делали обзор каждого из них в других статьях нашего блога, то не будем повторяться, а просто укажем источники для ознакомления:

-

краткий обзор возможностей «Google. Webmaster» рассмотрен в статье «Как перезапустить сайт и не потерять результаты в поиске»;

-

а вот в материале, который называется «Как избежать типичных ошибок при поисковой оптимизации. Мифы, советы, инструменты» рассмотрен сервис «Яндекс. Вебмастер».

Уверены, что там Вы найдете и много других полезных и интересных «фишек» и фактов.

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txt

Это обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, загрузите его в специальную форму на странице Яндекс.Вебмастер или воспользуйтесь отдельным инструментом в .

Файл Sitemap

Еще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно на странице Яндекс.Вебмастер, а также в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.